「研究でAIを使いたいが、倫理的に問題ないか不安」「大学院でAI活用について明確な指針がなく判断に迷う」「研究の信頼性を保ちながらAIの恩恵を受けたい」。このような悩みを抱える研究者や学生は急増しています。

生成AIの急速な普及により、学術界では前例のない課題に直面しています。AIは論文執筆の効率化や表現力向上において大きな可能性を秘めていますが、同時に研究倫理、知的誠実性、学術的価値に関わる深刻な問題も提起しています。

この記事では、国際的な学術機関や研究倫理委員会の動向を踏まえながら、学術ライティングにおけるAI活用の倫理的ガイドラインを包括的に解説します。研究者が安心してAIを活用し、学術的な価値と倫理的な責任を両立させるための実践的な指針を提供します。

学術界におけるAI活用の現状と課題

AI技術の急速な進歩と学術界への影響

ChatGPTをはじめとする大規模言語モデルの登場により、学術ライティングの環境は2022年以降劇的に変化しました。従来は専門的なスキルを要した文章執筆、翻訳、引用整理などの作業が、短時間で高品質に実行可能になったのです。

学術界でのAI活用の急拡大: 2023年の調査によると、研究者の約60%がすでに何らかの形でAIを研究活動に利用していることが明らかになっています。特に非英語圏の研究者にとって、英語論文の執筆支援は大きなメリットとなっています。

既存の研究倫理体系との齟齬: しかし、従来の研究倫理や論文執筆の規範は、AI技術の存在を前提としていませんでした。そのため、「何がAI活用として許容されるのか」「どこまでが研究者自身の成果といえるのか」という基本的な疑問に対する明確な答えがない状況が続いています。

世界の主要学術機関の対応状況

米国の動向: アメリカ心理学会(APA)は2023年、AI生成コンテンツの使用について「透明性の確保」と「著者責任の明確化」を求めるガイドラインを発表しました。また、多くの大学が独自のAI使用方針を策定し始めています。

欧州の動向: 欧州の主要大学は、AI活用を全面的に禁止するのではなく、「適切な使用方法の教育」に重点を置いたアプローチを取っています。研究倫理教育の一環としてAIリテラシーの向上を図っています。

日本の現状: 日本学術会議をはじめとする国内の学術機関でも、AI活用のガイドライン策定が進められています。ただし、分野横断的な統一見解の形成には時間を要している状況です。

分野別のAI活用状況と課題

理系分野での活用: データ解析、コード生成、論文の英文校正など、技術的な側面でのAI活用が進んでいます。一方で、研究データの解釈や結論導出にAIを使用することの妥当性については議論が分かれています。

文系分野での課題: 人文・社会科学分野では、AIが生成するテキストの「オリジナリティ」や「知的創造性」に関する懸念が特に強く表れています。文献解釈や理論構築における人間の思考プロセスの重要性が改めて議論されています。

AI活用がもたらす具体的な利益と可能性

研究効率の劇的な向上

文章執筆プロセスの効率化: AIを活用することで、論文の初稿作成にかかる時間を30-50%短縮できることが複数の研究で報告されています。これにより、研究者はより本質的な研究活動に時間を充てることが可能になります。

多言語対応の革命: 非英語圏の研究者にとって、AIによる翻訳・校正支援は研究成果の国際発信を大幅に促進する可能性があります。従来は言語の壁により国際的な議論に参加しにくかった優秀な研究者の声が世界に届きやすくなります。

研究の質的向上への貢献

文献レビューの体系化: 大量の先行研究を効率的に整理・分析することで、より包括的で精度の高い文献レビューが可能になります。見落としがちな関連研究の発見や、研究分野間の新たな関連性の発見にも寄与します。

論理構造の最適化: AIは論文の論理的整合性やアーギュメントの構造について客観的な分析を提供できます。これにより、より説得力のある論文構成の実現が期待できます。

アクセシビリティの向上: 複雑な研究内容をより分かりやすく表現することで、専門外の読者にも理解しやすい論文作成が可能になります。学際的な研究や社会実装において重要な要素です。

研究機会の民主化

技術的格差の縮小: 高度な文章技術や言語能力を持たない研究者でも、AIの支援により高品質な論文を執筆できる可能性があります。これは研究機会の平等化に大きく貢献する可能性があります。

新興研究分野での支援: 確立された方法論が存在しない新しい研究分野において、AIは研究設計や分析手法の提案を通じて、研究の発展を加速させる可能性があります。

AI活用に伴う重大な倫理的課題

知的誠実性と研究倫理の根幹に関わる問題

オリジナリティの定義の曖昧化: AIが生成した内容をどの程度自分の研究成果として扱えるかという問題は、学術界の根幹を揺るがす重要な課題です。従来の「独創性」や「新規性」の概念を根本的に見直す必要があります。

研究者の思考プロセスの軽視: AIに頼りすぎることで、研究者自身の批判的思考力や分析能力の発達が阻害される可能性があります。特に若手研究者の教育において、この問題は深刻な影響を与える可能性があります。

学術的価値の希薄化: AIが大量の類似した研究を生産することで、真に価値のある独創的な研究が埋もれてしまう危険性があります。学術界全体の質的向上に逆行する結果を招く可能性があります。

情報の正確性と検証責任

ハルシネーション(幻覚)問題: AIは存在しない文献や誤った情報を自信を持って提示することがあります。これらの誤情報が学術論文に含まれることで、研究コミュニティ全体に深刻な混乱をもたらす可能性があります。

引用の捏造リスク: AIが生成する引用情報は、実在しない論文や誤った著者情報を含む場合があります。これは研究不正の最も深刻な形態の一つであり、研究者のキャリアを破綻させる可能性があります。

検証責任の所在: AI生成情報の正確性を誰がどのように検証するのかという責任の所在が不明確です。最終的には論文著者が全責任を負うことになりますが、その検証プロセスの標準化が急務です。

著作権と知的財産権の複雑化

学習データの出典問題: AIが学習に使用した膨大なデータの中には、著作権で保護された文章や論文が含まれている可能性があります。AI生成コンテンツが既存の著作物と類似している場合、無自覚な著作権侵害のリスクがあります。

集合知の個人帰属化: AIは人類の集合的な知識を学習していますが、その成果を個人の研究成果として発表することの倫理的妥当性について議論が続いています。

透明性と再現可能性の問題

研究プロセスの不透明化: AIを使用した研究プロセスが適切に記録・開示されない場合、研究の再現可能性が大幅に損なわれる可能性があります。これは科学的方法の基本原則に反します。

バイアスの増幅: AIシステムが持つバイアスが研究結果に影響を与える可能性があります。特に社会科学や人文科学の分野では、このバイアスが深刻な問題となる可能性があります。

実践的な倫理ガイドラインと行動指針

透明性確保の具体的方法

AI使用の明示的記載: 論文やレポートにおいて、AI使用の有無、使用したAIの種類、使用範囲、使用目的を明確に記載することが必要です。多くの学術誌が「AI使用に関する著者声明」の提出を求め始めています。

使用記録の詳細な保持: 研究プロセスにおけるAI使用の記録を詳細に保持し、必要に応じて開示できる体制を整えることが重要です。これには使用したプロンプト、生成された回答、それに対する人間の判断プロセスの記録が含まれます。

方法論セクションでの説明: 論文の方法論セクションにおいて、AIをどのような分析ツールとして使用したかを、他の研究ツールと同様に詳細に説明する必要があります。

段階別AI活用の適切性評価

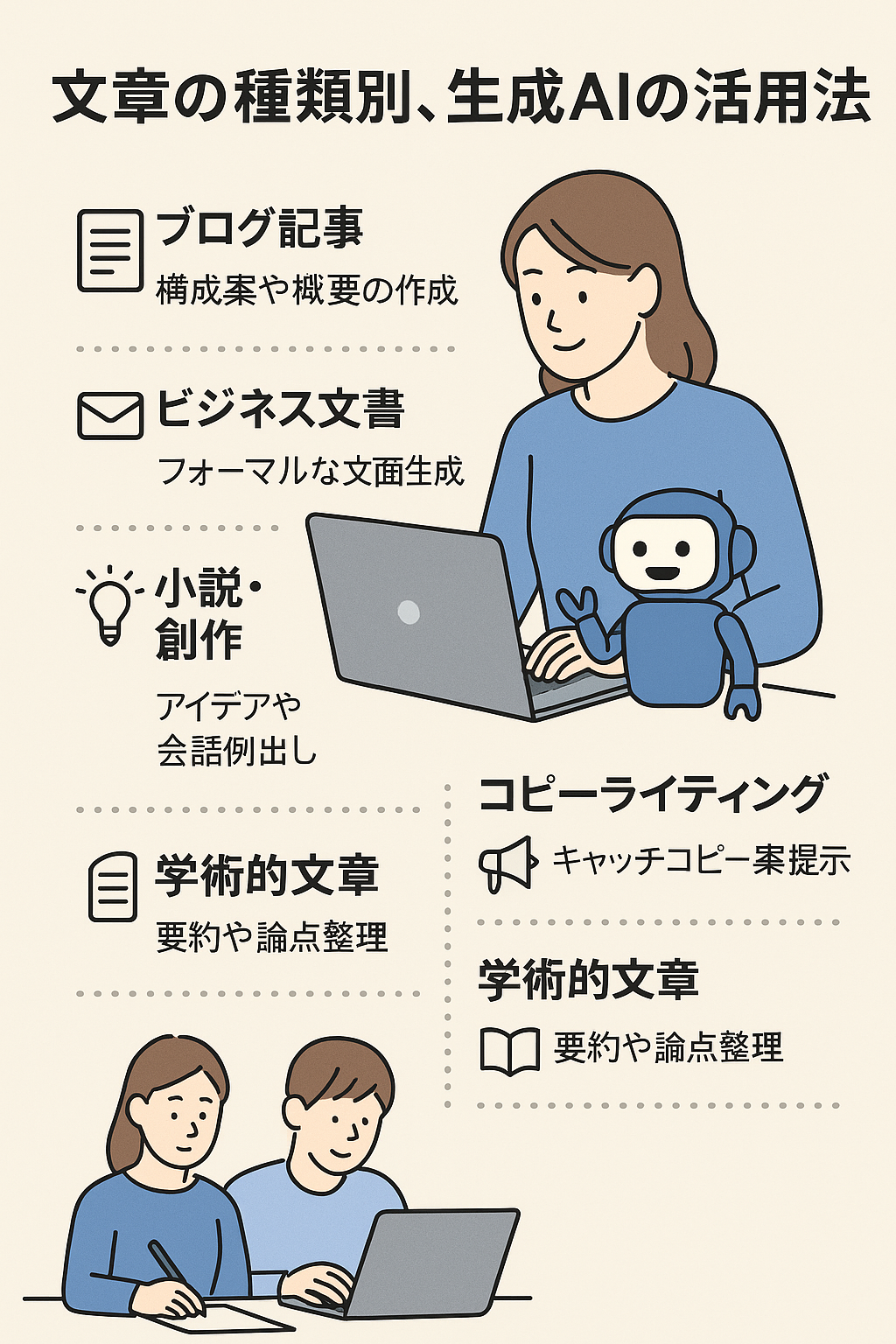

許容される活用範囲:

- 文法・スタイルチェックと表現改善

- 英文校正と翻訳支援

- 論文構成の提案とアウトライン作成

- 文献検索キーワードの提案

- データ可視化の支援

注意深い検討が必要な活用:

- 文献レビューの要約作成

- 研究仮説の生成支援

- 調査項目・質問文の作成

- 統計分析結果の解釈支援

- 考察部分の論理構成支援

避けるべき活用:

- 研究結果・結論の完全AI生成

- データ分析・統計処理の完全委託

- 理論的枠組みの完全AI依存

- 批判的考察の外部委託

- 引用文献の無検証使用

検証プロセスの標準化

多層的検証システム: AI生成情報については、以下の段階的検証を実施することを推奨します:

- 生成内容の論理的整合性確認

- 事実関係の一次資料による裏付け

- 既存研究との整合性確認

- 専門家による内容評価

- 最終的な著者責任での承認

引用・参考文献の厳格な確認: AIが提案する引用については、必ず原典にあたり、以下の項目を確認します:

- 文献の実在性

- 著者名・出版年・出版社の正確性

- 引用箇所の文脈適合性

- 引用形式の規格適合性

共著者・指導者との合意形成

研究チーム内での方針統一: 共同研究においては、AI使用に関する方針を事前に合意し、文書化することが重要です。各著者の責任範囲とAI使用範囲を明確に定義する必要があります。

指導教員との相談体制: 学生研究者は、AI使用について指導教員と密に相談し、教育的観点からの適切な指導を受けることが必要です。AI活用スキルの向上と学術的思考力の発達を両立させる指導が求められます。

分野別・用途別の詳細ガイドライン

理工学分野での特別な配慮事項

データ分析におけるAI使用: 統計解析やデータ処理にAIを使用する場合、使用したアルゴリズムの詳細、パラメータ設定、検証方法を詳細に記録し、再現可能性を確保することが重要です。

コード生成の倫理: AIが生成したプログラムコードを研究に使用する場合、そのコードの動作確認、最適化、ドキュメント化は研究者自身が責任を持って行う必要があります。

人文・社会科学分野での特別な配慮事項

解釈学的研究でのAI活用: テキスト解釈や文化分析においてAIを使用する場合、AI生成の解釈を研究者自身の批判的思考で検証し、独自の学術的視点を加えることが不可欠です。

質的研究におけるAI支援: インタビュー分析やエスノグラフィー研究でAIを活用する場合、人間の主観性や文脈理解の重要性を軽視しないよう注意が必要です。

学際的研究での配慮事項

複数分野の倫理基準の統合: 学際的研究では、関連する各分野の倫理基準を考慮し、最も厳格な基準を適用することが安全です。分野間でAI使用の許容度が異なる場合の調整が重要です。

教育現場でのAI活用指導

学部生・大学院生への教育方針

段階的AI活用能力の育成: 学習段階に応じて、AI活用の範囲と責任を段階的に拡大することが重要です。基礎的な研究スキルを身につけた上で、AIを効果的に活用できる能力を育成します。

批判的思考力の維持・向上: AI活用により効率化を図る一方で、学術的な批判的思考力や分析能力の発達を阻害しないよう、バランスの取れた教育プログラムの設計が必要です。

評価・採点における配慮

AI検出ツールの限界理解: AI生成テキストの検出ツールには限界があり、完全な判定は困難です。技術的な検出に頼るのではなく、教育的な指導とコミュニケーションを重視したアプローチが重要です。

新しい評価方法の開発: 従来の課題やテストに加えて、AI時代に適応した新しい評価方法の開発が求められています。プロセス重視の評価、口頭試問、実践的な課題などの活用が考えられます。

学術出版界の動向と対応策

主要学術誌の方針動向

Natureグループの対応: Nature系列の学術誌では、2023年より「AI生成コンテンツは著者として認められない」「AI使用は方法論で明示する」という明確な方針を打ち出しています。

Elsevier・Springer等の対応: 主要出版社は相次いでAI使用に関するガイドラインを発表し、著者に対する透明性の確保を求めています。査読プロセスにおけるAI使用の検証も強化されています。

査読プロセスの変化

査読者向けガイドライン: 多くの学術誌が査読者に対して「AI使用の可能性を考慮した査読」を求めるガイドラインを発表しています。査読者自身のAI使用についても規定が設けられています。

新しい査読基準の導入: 従来の新規性・妥当性に加えて、「AI使用の適切性」「透明性の確保」「研究者の知的貢献の明確性」などが新たな評価基準として導入されています。

技術の進歩に対応した継続的なガイドライン更新

新技術への対応準備

マルチモーダルAIへの対応: テキストだけでなく、画像、音声、動画を統合的に処理できるAIの登場により、新たな倫理的課題が生まれています。これらの技術に対応したガイドラインの継続的な更新が必要です。

AI能力の向上への適応: AIの能力が向上するにつれて、許容される使用範囲や必要な検証レベルも変化していきます。技術の進歩に合わせた柔軟なガイドライン運用が求められます。

国際的な標準化の動向

UNESCO・EU等の取り組み: 国際機関レベルでのAI倫理に関する議論が活発化しており、学術界での標準化も進んでいます。これらの国際的な動向を注視し、整合性を保つことが重要です。

分野横断的な協力体制: 学術分野を超えた協力により、統一的で実用的なガイドラインの策定が進められています。個別の分野だけでなく、学術界全体での取り組みが重要です。

将来展望と提言

AI時代の研究者に求められる新たな能力

AIリテラシーの必修化: 今後の研究者には、AI技術の基本的理解、適切な活用方法、限界の認識といったAIリテラシーが不可欠になります。大学院教育カリキュラムへの組み込みが急務です。

倫理的判断力の重要性: 技術の進歩に伴い、個々の研究者の倫理的判断力がより重要になります。ガイドラインに頼るだけでなく、自律的な倫理判断ができる研究者の育成が必要です。

学術界全体の体制整備

制度的サポートの充実: 大学や研究機関レベルでの相談窓口設置、研修プログラムの充実、技術的サポート体制の整備が求められています。

継続的な議論と改善: AI技術と学術界の関係は発展途上であり、継続的な議論と改善が不可欠です。研究コミュニティ全体での活発な意見交換と経験共有が重要です。

まとめ:責任ある研究者としてのAI活用

学術ライティングにおけるAI活用は、適切に行えば研究の効率化と質的向上を同時に実現できる強力なツールです。しかし、その活用には高い倫理的責任と専門的判断力が伴います。

重要な基本原則:

- 透明性の確保:AI使用を明確に開示し、検証可能な記録を保持

- 補助ツールとしての位置づけ:AIに依存せず、研究者主体の研究プロセスを維持

- 厳格な検証責任:AI生成情報の正確性を一次資料で確認

- 継続的な学習:技術進歩と倫理基準の変化に対応した継続的な能力向上

AI技術の進歩を恐れるのではなく、適切に活用することで研究の可能性を拡げることができます。同時に、学術界の根幹である知的誠実性、透明性、再現可能性を決して妥協してはなりません。

今後も技術の発展に伴い、新たな課題や機会が生まれ続けるでしょう。重要なのは、個々の研究者が責任ある判断を行い、研究コミュニティ全体で建設的な議論を続けることです。AI時代においても、人間の知的探求心と倫理的責任こそが、真に価値ある学術研究の源泉なのです。

コメント